Sexuální zneužívání dětí představuje jednu z nejhorších věcí, které se člověk může dopustit. Apple proti němu hodlá bojovat od iOS 15.

Apple odhalil nové funkce, které přijdou s iOS 15 ve svém tiskovém prohlášení. Mají se týkat hlavně bezpečné komunikace dětí na internetu a k dispozici budou nejdříve pro uživatele v USA. Časem se mají rozšířit i do dalších oblastí.

Sexuální zneužívání může začít posláním fotky

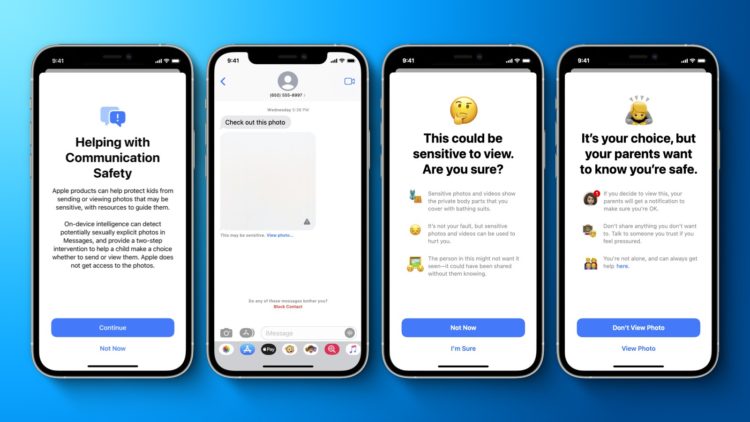

Aplikace Zprávy na iPhonu, iPadu a Macu dostane novou funkci pro bezpečnost komunikace, která varuje děti a jejich rodiče při přijímání nebo odesílání sexuálně explicitních fotografií. Apple uvedl, že aplikace Zprávy bude k analýze obrazových příloh používat strojové učení na zařízení, a pokud je fotografie určena jako sexuálně explicitní, bude automaticky vymazána a dítě bude varováno.

Když se dítě pokusí zobrazit fotografii označenou jako citlivou v aplikaci Zprávy, bude upozorněno, že fotografie může obsahovat nahé části těla a může být citlivá. V závislosti na věku dítěte bude mít rodič také možnost obdržet oznámení. Pokud si jeho dítě prohlíží citlivou fotografii nebo se po upozornění rozhodne odeslat sexuálně explicitní fotografii jinému kontaktu, vyskočí na rodiče notifikace.

Apple uvedl, že nová funkce pro bezpečnost komunikace bude k dispozici v aktualizacích iOS 15, iPadOS 15 a macOS Monterey koncem tohoto roku. Uživatelé také budou muset používat Rodinné sdílení na iCloudu. Kalifornská společnost ujišťuje, že konverzace v iMessage zůstanou chráněny šifrováním typu end-to-end, takže soukromá komunikace bude pro Apple nečitelná.

Skenování fotografií na iCloudu

Dalším vylepšením má být detekce fotografií na iCloudu. Počínaje letošním rokem s iOS 15 a iPadOS 15 bude Apple schopen detekovat fotografie, které jsou označeny zkratkou CSAM (Child Sexual Abuse Material). Podezřelé fotky s obsahem dětské pornografie bude moct Apple detekovat v případě, že budou uložené na iCloudu. Společnosti to umožní nahlásit tyto případy organizaci NCMEC (National Center for Missing & Exploited Children), která pomáhá pohřešovaným a zneužívaným dětem. Také spolupracuje s orgány činnými v trestním řízení, takže odhalení takové fotky bude znamenat velký problém pro jejího držitele.

Apple uvedl, že jeho metoda detekce fotek s CSAM je navržena s ohledem na soukromí uživatelů. Místo skenování obrázků v cloudu systém provede shodu na zařízení s databází označených fotografií. Databáze má být průběžně doplňována a hlavně zůstane nečitelná jako sada hashů a bezpečně uložena v zařízeních uživatelů.

Podle kalifornské firmy hashovací technologie, nazývaná NeuralHash, analyzuje fotku a převádí jej na jedinečné číslo specifické pro tento obrázek.

Hlavním účelem hashe je zajistit, aby stejné a vizuálně podobné obrázky vedly ke stejnému hashu, zatímco obrázky, které se navzájem liší, mají za následek různé hashování. Například obrázek, který byl mírně oříznut, změněna jeho velikost nebo převeden z barvy na černobílý, je považován za stejný jako jeho originál a bude mít stejný hash.

Před nahlášením proběhne ruční kontrola

Před uložením fotky do iCloud fotek je proveden proces shody na zařízení proti nečitelné sadě známých hash CSAM. Pokud dojde ke shodě, zařízení vytvoří požadavek na kryptografickou bezpečnost. Tento požadavek je nahrán na iCloud Fotky spolu s obrázkem a jakmile je překročen nezveřejněný práh shod, je Apple schopen interpretovat obsah pro CSAM. Apple poté každou zprávu ručně zkontroluje, aby potvrdil, že existuje shoda, deaktivuje uživatelský iCloud účet a odešle zprávu do NCMEC. Apple nesdílí, jaký je jeho přesný práh shod, ale zajišťuje prý extrémně vysokou úroveň přesnosti, aby účty nebyly nesprávně označeny.

Apple uvedl, že jeho metoda detekce známého CSAM poskytuje významné výhody pro ochranu soukromí oproti stávajícím technikám:

- Tento systém představuje účinný způsob identifikace známých CSAM uložených v účtech iCloud Photos při ochraně soukromí uživatelů.

- Jako součást procesu se uživatelé také nemohou dozvědět nic o sadě známých obrázků CSAM, které se používají pro párování. To chrání obsah databáze před škodlivým použitím.

- Systém je velmi přesný, s extrémně nízkou chybovostí. Je nižší než jedna z jednoho miliardu účtů ročně.

- Systém výrazně chrání soukromí než skenování v cloudu, protože hlásí pouze uživatele, kteří mají v iCloud Photos uloženou sbírku známých CSAM.

Základní technologie systému od Applu je poměrně složitá a podrobnosti si můžete přečíst na webu Applu ve speciálním dokumentu. John Clark, prezident a generální ředitel Národního centra pro pohřešované a zneužívané děti řekl:

Rozšířená ochrana Applu pro děti mění hru. S tolika lidmi, kteří používají Apple produkty, mohou tato nová bezpečnostní opatření lépe chránit dětské životy. Už nebude tolik případů sexuálního zneužívání a online predátoři to budou mít zase těžší.

S bezpečností pomůže také Siri

Apple dále uvedl, že rozšíří poradenství i do Siri a Spotlight Search. Poskytne tak další zdroj, kde se dá získat pomoc pro děti i rodiče. Například uživatelé, kteří se zeptají Siri, jak mohou hlásit CSAM nebo zneužívání dětí, budou upozorněni na zdroje, kde a jak podat hlášení.

Aktualizace Siri a Spotlight Search přijdou později v tomto roce v aktualizaci iOS 15, iPadOS 15, watchOS 8 a macOS Monterey.